Zotero文献管理和iPad批注并同步的坑

文献管理软件用过不少,从最早NoteExpress到牛逼的Citavi,再到Endnote。之前看文献一直都在用同济免费的Endnote,配合坚果云同步,在不同电脑上用也挺方便,最大的不方便有两个。第一是如果iPad上想看文献比较麻烦,只能专门挑出来一篇篇pdf通过坚果云同步后再iPad打开。第二是中文文献导入很麻烦,知网下了pdf,导入不能自动关联知网的论文信息,要手动知网下对应的导入文件(最多就是能批量导入)。

最近尝试换到zotero,虽然之前用Citavi的时候也玩过zotero,但是十年前的zotero还很不成熟,现在都有iPad版本的zotero了,试了下,能用,遂想着多设备同步来搞定文献管理。

需求

需求其实很简单,按照使用习惯,下文章一般都在电脑上,而且一般都直接是pdf文件(caj格式就是异端! )。第一,需要导入pdf后能自动关联文献信息。第二,多设备同步,包含多电脑同步以及iPad上阅读,iPad+pencil批注很方便,需要能同步批注信息。

实现形式

关联文献信息

这个实现很容易,这一步一般在电脑上实现,下好pdf导入。英文文献自动搜索并关联,中文文献有Jasminum插件(https://github.com/l0o0/jasminum)能实现。上周知网更改了元数据抓取方式,不过作者很快更新了插件,目前zotero 6的插件抓取知网信息已经没问题了,zotero 7不清楚。

虽然不是自动完成,但是依靠这个插件,右键再选择一下,已经能解决99%的问题了。

同步

文献同步还是用坚果云,通过webdav方式。

iPad阅读和批注

官方现在有zotero app,刚开始还挺好用,支持简单的批注,不过前段时间突然出现同步的pdf附件不能打开的情况,一直提示“The attached file could not be found”。电脑端没什么问题,不同电脑端也没问题,就只有iPad端找不到文件,网上有教程说通过电脑端“首选项-同步-重置-重置文件同步历史”的做法可以修复,不过我尝试了没用,所以这个官方app也差不多是个废物了,还有待改进。

还有一种方法是通过PaperShip app直接关联zotero的webdav同步,阅读没问题,要批注的9.99美元。要是软件好用的话这9.99刀也不是很贵,不过这app上一次更新已经是4年前了,网上也同样有很多不能同步批注的问题,所以想想这9.99刀还是省了。

昨天洗澡的时候想到其实我要的需求实现起来不难,文件已经是放到了网盘,只需要支持阅读和批注的pdf软件去读pdf,看完将批注和原来的pdf合并成一个文件返回给网盘就行,应该有人和我有一样的需求的呀。而且pdf阅读批注重新打包上传是很容易实现的,就是pdf阅读器加个网络连接的问题。完美一点是实现和zotero一样的批注保存方式,独立保存,这样就需要完全匹配zotero桌面端批注保存的样式和格式。

今天花了点时间搜了下,确实同样需求的人很多,实现起来其实也不难。用到的是Zotfile插件(https://github.com/jlegewie/zotfile),实现方式有两种:通过zotfile的平板模式实现和通过自定义同步实现。iPad端app都是pdf expert,可以通过webdav链接,并且批注方式很多样。

- 通过zotfile平板模式实现

主要参考这个介绍

原理是新建一个同步文件夹(可以认为是暂存盘),平时是空文件夹状态。要读哪个文献了,通过插件将pdf发送到这个暂存盘,iPad上的阅读批注软件通过连接这个同步文件夹打开pdf。阅读批注完后会自动同步上传到暂存盘,然后电脑上再通过这个插件取回文件,比较同步文件夹中的文件有没有修改,有修改,就替换掉现在zotero同步盘中的对应pdf,同时删除暂存盘中的文件,暂存盘恢复空文件夹状态。

(这个方法最容易搜到,尝试了下太多步骤,手动发送再取回文件的操作着实不符合自动化的定义,放弃)

- 通过zotfile自定义同步实现

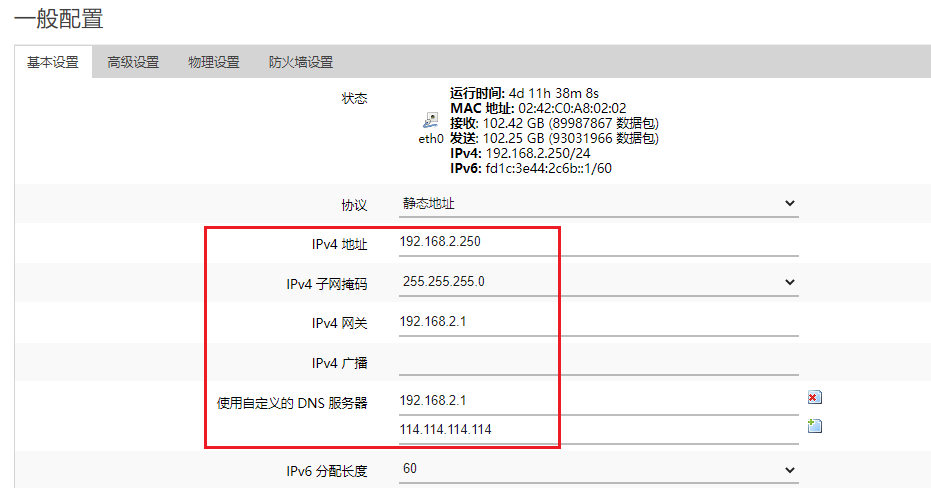

Zotfile可以通过改变zotero管理pdf的方式来实现自定义同步。zotero默认将pdf打包成自定命名规则的zip包同步,webdav同步这些zip包,双击打开文件操作是直接打开文献条目对应的zip包内的pdf文献,同步盘同步的是这些文献包。而Zotfile可以将文献条目下的对应文件从pdf文件换成pdf链接(pdf图标上有个链接图标了)。

这样zotero同步的就是这些pdf文件链接了,pdf真实文件可以在任何可以访问的网络上。

在这个基础上,再弄个同步盘,专门用来同步pdf文件不就行了,iPad上阅读批注都访问这个文件夹,zotero通过链接访问这些有批注的文件,就能完美搞定文件同步和批注同步了。

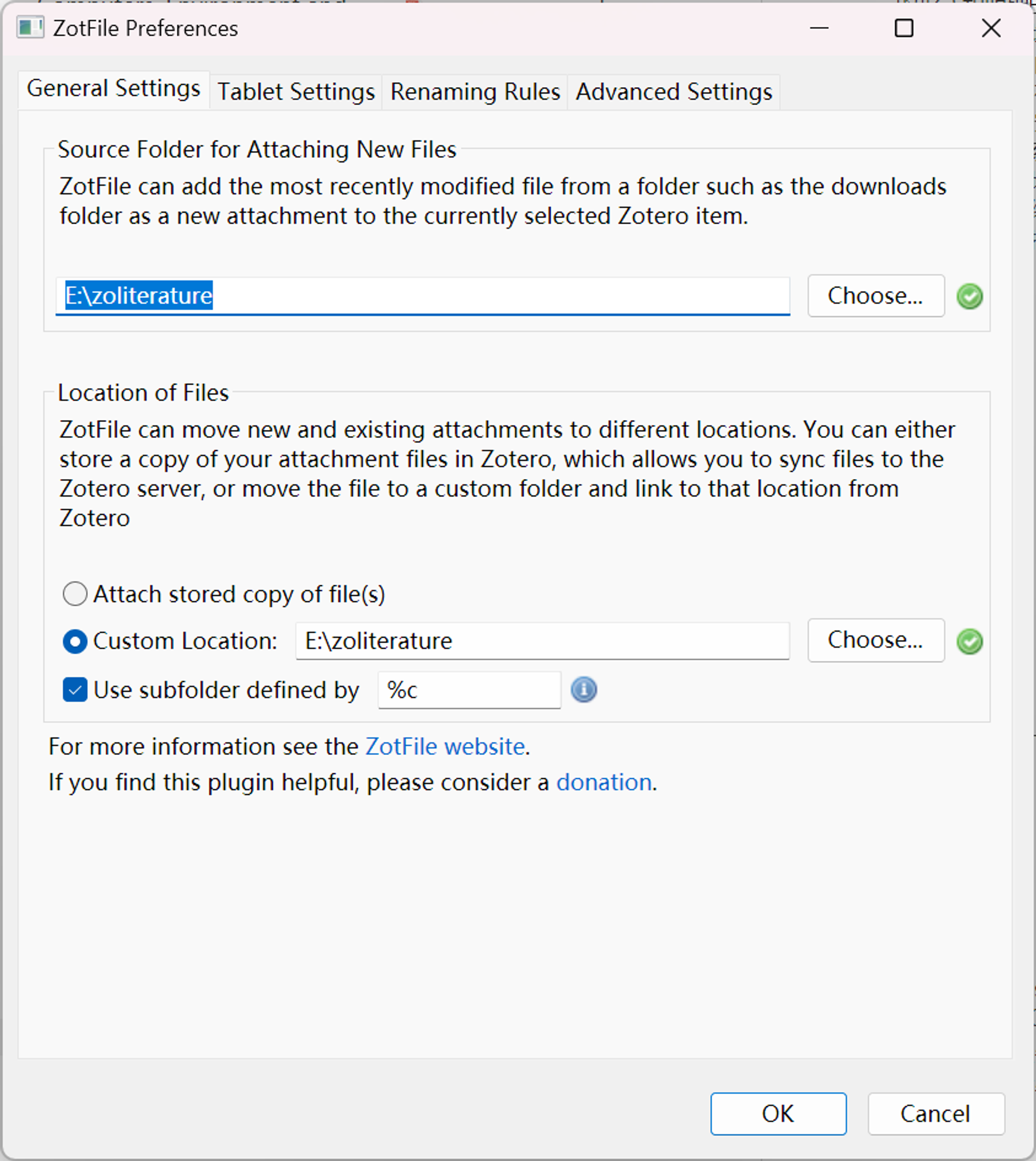

设置也不难,Zotfile设置第一页就有自定义文件位置的设置,坚果云新建一个同步文件夹用来存放所有pdf,还能根据分类(%c)放到不同分类文件夹下,设置好后所有文件选中,右键——Manage Attachments——Rename and move,不仅能根据作者文献名命名pdf,还归类好了文件夹。

这样设置完后其实iPad上用pdf expert连接webdav看文献作批注已经可以了,但是到另一台电脑上后出现了pdf打不开的问题,提示是绝对路径下没有这个pdf文件,当时没截图(摊手)。类似A电脑上同步pdf的文件夹放在E盘,B电脑同步文件夹在D盘,B电脑上打开pdf就会提示找不到E:XXXXXX.pdf。这不就是绝对路径和相对路径问题么,搜到下面这个页面能解决。

Zotero多平台同步附件踩坑:如何设置zotfile的custom location

通过设置zotero链接文件路径和同步路径相同就行。

这样基本就完美了。

尚待实现

- 前面提到zotero是将批注和文献pdf分开存放的,这样就不破坏原pdf,现在这样的方法,批注其实是和原pdf合并在一个文件了。这样情况下,电脑上对文献的批注是不能在iPad上看到的,而iPad上的批注会增大pdf文件。不过都是文献而已,这两个都不算问题。

- 书的导入还是个问题,特别是中文书,之前一直想稿豆瓣读书能不能一键导入文献管理软件,找时间也看看实现方式。